书生 · 浦语大模型全链路开源开放体系 ¶

约 223 个字 11 张图片 预计阅读时间 1 分钟

Abstract

书生 · 浦语大模型系列 ¶

- 轻量级:InternLM-7B

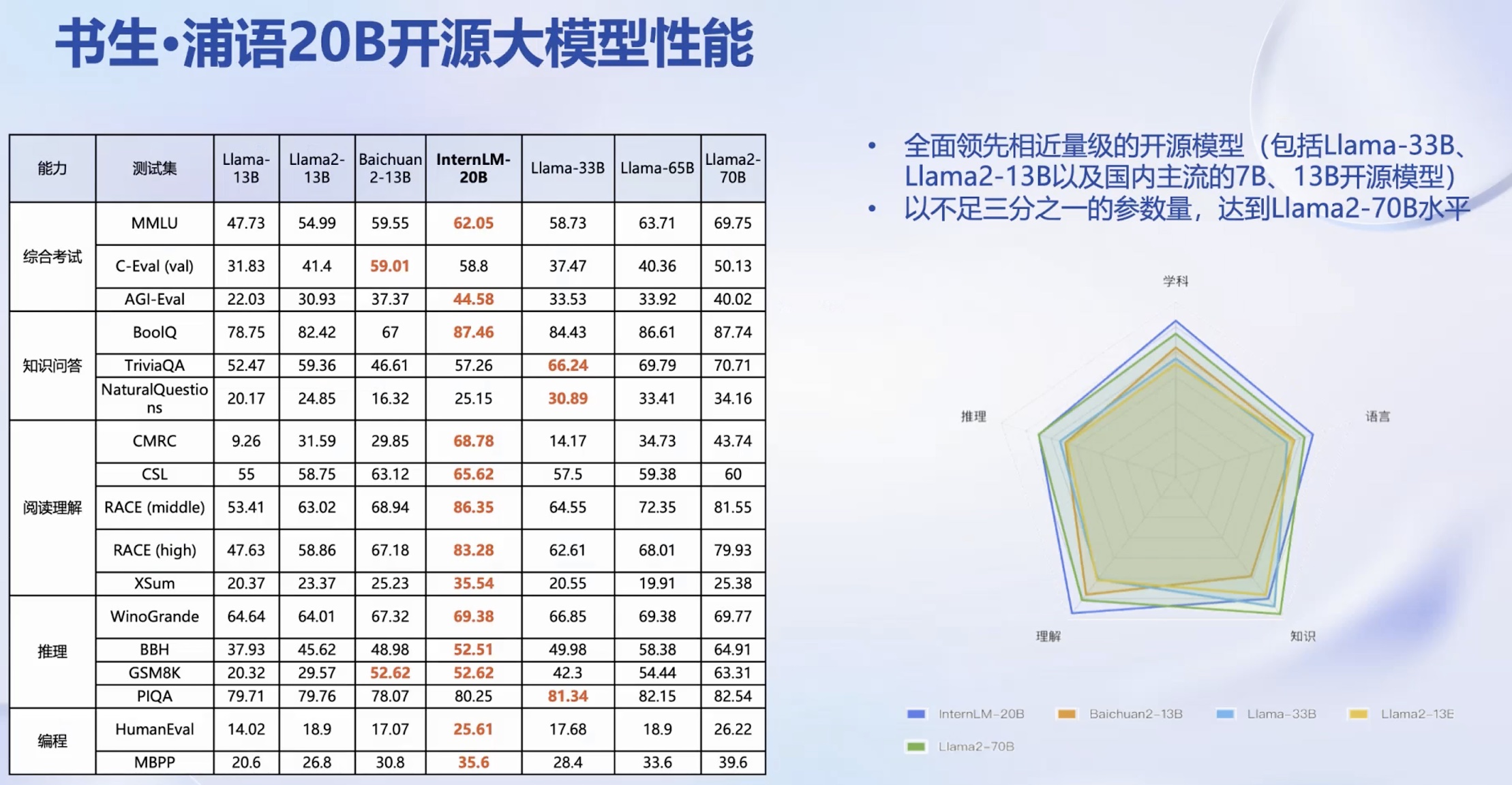

- 中量级:InternLM-20B

- 重量级:InternLM-123B

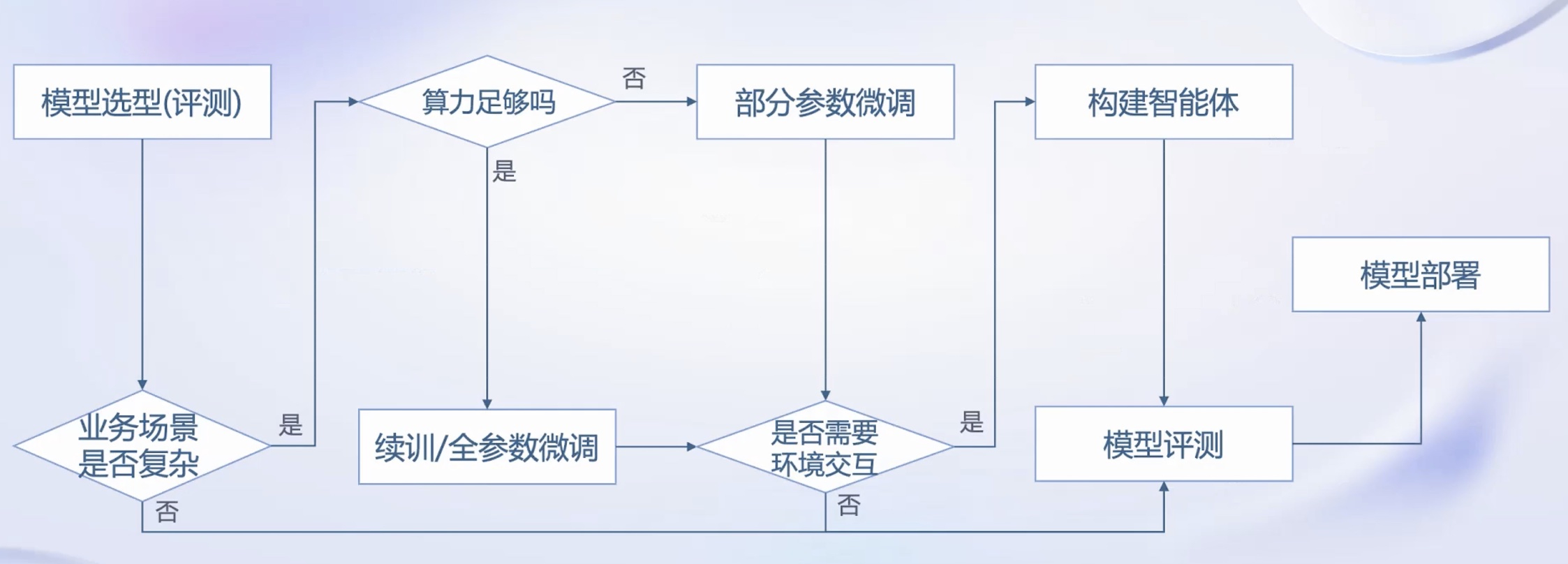

从模型到应用 ¶

书生 · 浦语大模型全链路开源开放体系 ¶

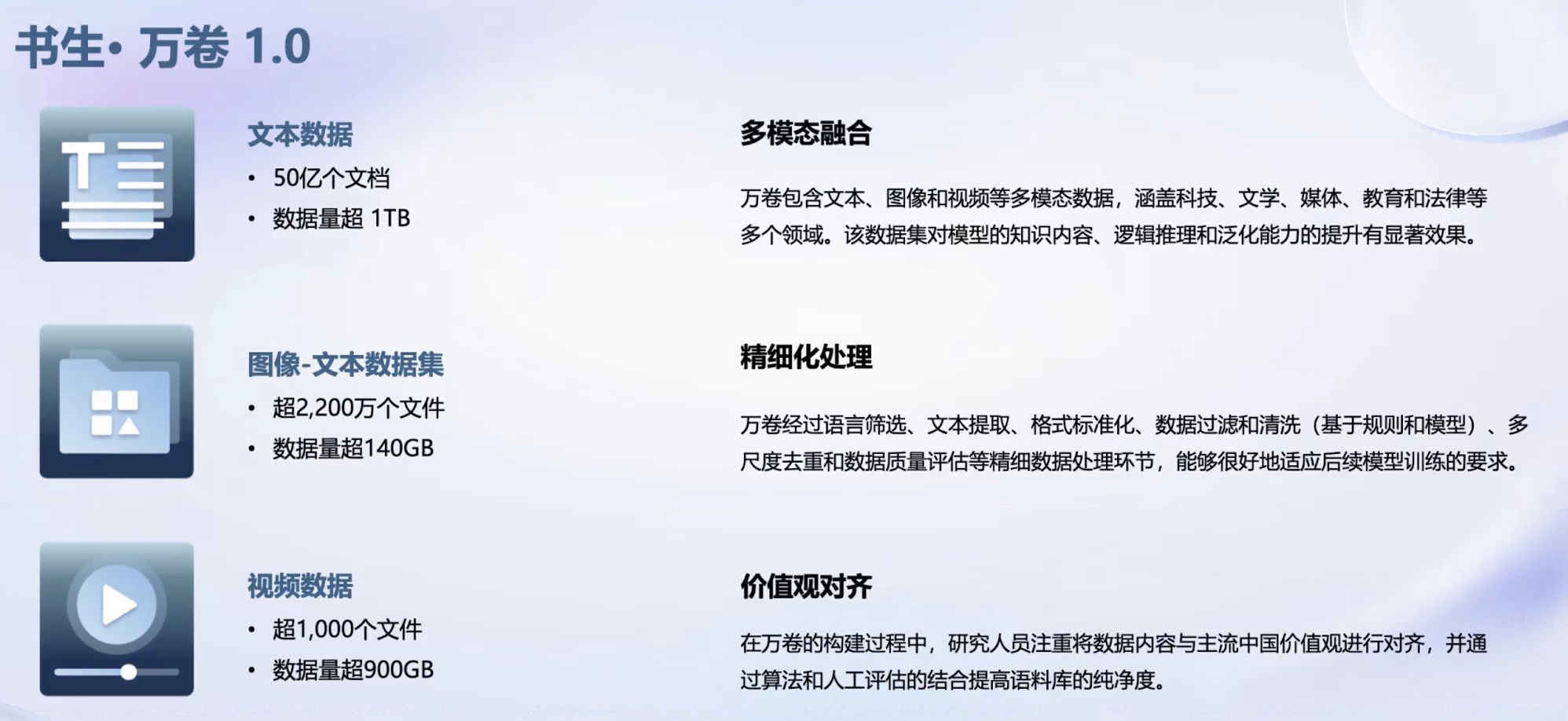

数据:书生 · 万卷 ¶

具体查看 openDataLab。

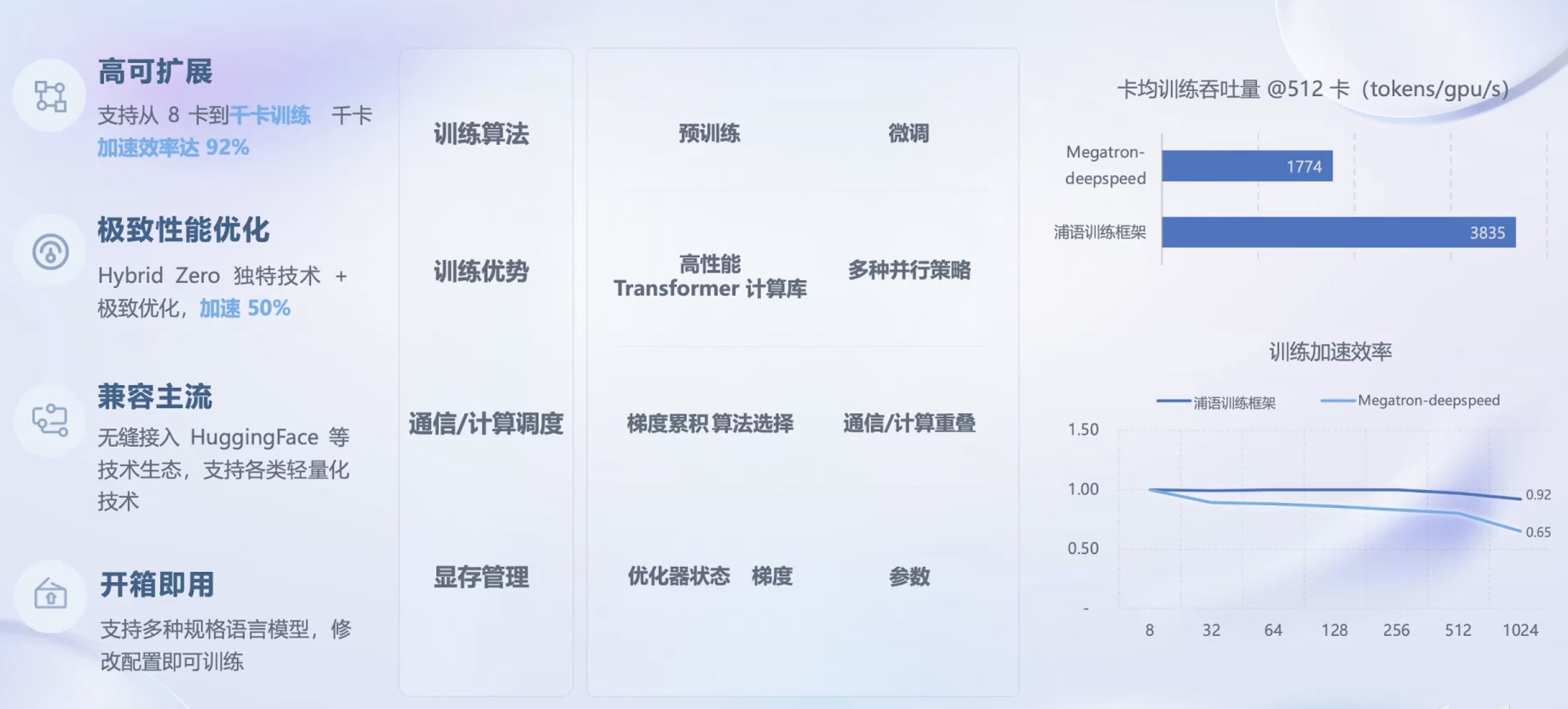

预训练:InternLM-Train¶

微调:XTuner¶

大语言模型的下游应用中,增量续训和有监督微调是经常会用到两种方式。

- 增量续训

- 使用场景:让基座模型学习新知识,如某个垂类领域知识

- 训练数据:文章、数据、代码等

- 有监督微调

- 使用场景:让模型学会理解和遵循各种指令,或者注入少许领域知识

- 训练数据:高质量的对话、问答数据

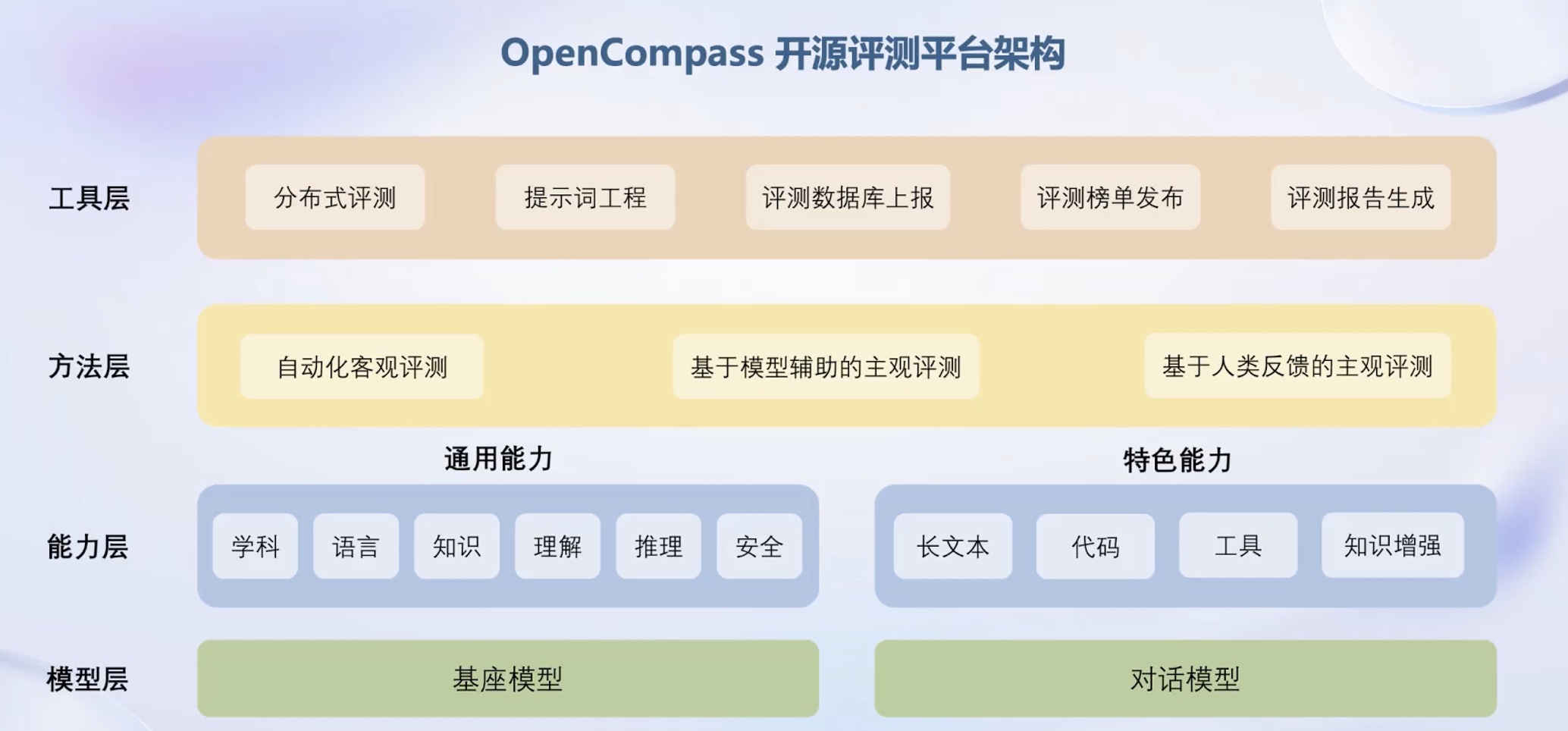

评测:OpenCompass¶

部署:LMDeploy¶

应用:Lagent、AgentLego¶